七彩虹 iGame RTX 2080 Advanced OC 显卡使用感受(容量|功耗|画面)

-

摘要来自:

-

摘要来自:

黑山老妖LYN

黑山老妖LYN -

摘要来自:2019-04-04

【什么值得买 摘要频道】下列精选内容摘自于《RTX2080笑怼GTX1080Ti—COLORFUL 七彩虹 iGame RTX 2080 Advanced OC显卡 开箱及详测》的片段:

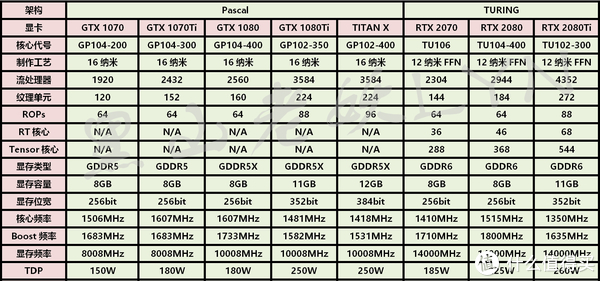

这次NVIDIA老黄非常嘚瑟的发布了三款采用全新图灵架构的新显卡:RTX 2080Ti、RTX 2080、RTX 2070,分别基于TU102、TU104、TUF106等三个不同的核心。为了拉开与专业显卡以及新一代TITAN的距离,所以RTX 2080Ti和RTX 2080都没有使用完整的TU102和TU104核心,而是采用了精简版。RTX 2080 Ti的GPU核心代号TU102-300, 4352个CUDA、272个纹理单元、88个ROP单元、68个RT核心、544个Tensor核心。GPU核心的基础频率为1350MHz,Boost加速频率公版为1635MHz,此次与以往不同,以往都是公版频率偏低,而非公版的频率普遍要高于公版,但是这次的情况却是相反,老黄对公版Founders Edition的定价更高(莫非真的觉得有收藏价值?),因此频率也比非公版要高。据说非公版RTX 2080Ti的Boost加速频率为1545MHz,不过根据后面接连上市的非公版显卡来看,其实都没有做严格的限定。显存方面采用的是GDDR6颗粒,容量为11GB,显存位宽384bit,等效频率14GHz,带宽为616GB/s,整卡TDP功耗260W。RTX 2080的GPU核心代号TU104-400,2944个CUDA、184个纹理单元、64个ROP单元、46个RT核心、368个Tensor核心。GPU核心基础频率1515MHz,Boost加速频率公版为1800MHz、非公版为1710MHz,同样采用GDDR6显存颗粒,容量为8GB,显存位宽减少为256bit,等效频率也是14GHz,带宽为448GB/s,整卡功耗225W。RTX 2070采用的则是完整的TU106核心,2304个CUDA核心、144个纹理单元、64个ROP单元、288个Tensor核心、36个RT核心,搭配8GB的GDDR6显存,显存位宽256-bit,等效频率依然是14GHz。GPU核心基础频率1410MHz,Boost加速频率公版为1710MHz、非公版1620MHz,整卡功耗185W。从硬件规格上看,RTX 2080对比RTX 2080Ti的精简力度还是不小的,但是GPU核心的频率要更高一些,以此来提升性能、抵消硬件规格缩减带来的性能损失。

按照NVIDIA以往的产品定位来看,中端显卡一般都是性价比最高的甜点级产品。RTX 2080的售价只有RTX 2080Ti的三分之二,而根据之前媒体的评测,性能却能够达到RTX 2080Ti的75%。因此,RTX 2080性价比更高,而且价格更加亲民。目前AMD方面还没有哪个新一代的显卡能够正面与RTX 2080交锋,因此RTX 2080的主要对手还是上一代的自家旗舰GTX 1080Ti。接着来看看图灵新架构究竟具有哪些新技术。图灵Turing核心采用台积电12nm FFN工艺,对比上一代的Pascal架构,图灵具有更大的核心面积和更先进的制程。除了CUDA核心规模继续增大、Shading着色渲染升级之外,最主要的技术革新是加入了全新的专为光线追踪计算服务的RT CORE以及为实时游戏画面导入AI人工智能加速的TENSOR CORE。

1、RT CORE与实时光线追踪技术

光线追踪并非是新的概念,光线追踪技术就是将光源光线所产生的反射、折射等光线变化以及由此对阴影产生的影响通过计算准确的反映到画面之中,使得光影效果更加接近现实。简单来说,就是让光源与物体产生更多地交互,从而提升画面的真实感和氛围感。不过在此之前的各种技术都需要耗费大量的计算资源,因此一般都是使用超级计算机来运算,应用在专业领域。这些技术也没有得到大范围的推广普及。因为起点太高,以前的显卡想要进行实时的光影追踪运算,几乎全部都累趴下,所以普通游戏玩家在游戏中是体验不到实时光线追踪效果的。而此次图灵核心中新增的RT CORE就是专门为了光线追踪技术而设计的。RT CORE配合光线追踪的计算公式,专门用于光线追踪的庞大运算,让图灵架构的新显卡能够轻松搞定用于打造光影追踪效果的各项计算。

上面是NVIDIA官方DEMO的截图,图一是单一光源照射到众多物体上,RTX技术可以准确计算出随着观看角度的不同,物体阴影所产生的变化。图二是几个光源同时影响众多物体的阴影的效果。图中同时存在数处光源,各个光源都影响着物体的阴影,RTX技术能够准确计算出各个物体的阴影效果。

2、TENSOR CORE和DLSS

图灵架构的另外一记“重拳”是基于AI人工智能技术的“深度学习超级采样抗锯齿”(DLSS)技术。对于抗锯齿技术,我相信广大玩家都不陌生,各大游戏厂家往往都需要借助各种抗锯齿技术来让画面更细腻更逼真,但是开启更高级别的抗锯齿,意味着需要消耗更多的显卡资源,性能差一点的显卡会直接累趴下,游戏画面也会出现各种卡顿。DSLL技术简单一点来说,就是NVIDIA会在超级计算机上通过采集超级多个以64倍超级采样生成的参考画面,再用一定的方式挑选出一些画面作为完美渲染的“标准答案”,然后通过DLSS人工智能深度学习,将标准分辨率的画面和这些画面进行对比,生成一张最优画面,再与64倍超级采样进行对比,得出差别后把这些差别反馈到神经网络中,进行循环训练。这样反复多次之后人工智能网络就可以学会如何将标准画面渲染到接近64倍超级采样原图的方法。这些学习成果会定期通过软件更新(例如GFE软件推送和驱动程序升级)提供给采用图灵GPU的显卡,通过TENSOR CORE就可以进行实时对比,从而把较低分辨率的画面“脑补”为高分辨率画面,实现画面质量的提升。这个过程中的绝大部分运算都是在NVIDIA的超级计算机上来完成的,DLSS技术能够尽可能的降低本地的GPU资源消耗(云显卡???),让性能较差的显卡也能够获得更出色的画质。目前同时支持RTX光线追踪和DLSS抗锯齿技术的游戏非常少,像《古墓丽影:暗影》和《最终幻想15》这些游戏都需要等待官方提供升级补丁才能支持。